L'intelligence artificielle peut-elle égaler le traitement du son par le cerveau ?

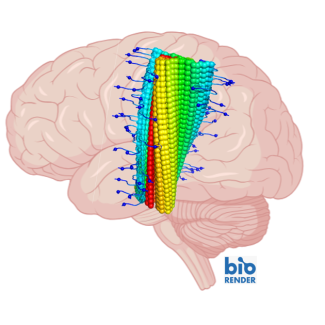

Sans que nous le réalisions, notre cerveau traite en continue des informations acoustique et déduit des informations sémantiques. Par exemple, il déduit la présence d'oiseaux dans l'arbre à partir de leurs chants. Mais comment reproduire ce processus avec des modèles d’intelligence artificielle, ou plutôt « d’écoute artificielle » ? Pour la première fois, une équipe de recherche menée par Bruno Giordano, chercheur du CNRS à l’Institut de neurosciences de la Timone (CNRS/Aix-Marseille Université) en collaboration avec le professeur Elia Formisano de l’Université de Maastricht, vient de comparer les modèles d’écoute artificiels actuels pour déterminer lequel explique mieux la perception et la représentation cérébrale des sons. Leurs travaux montrent que les modèles dits « réseaux de neurones profonds »1 surpassent de loin les autres, le meilleur d’entre eux étant des algorithmes développés par Google. Les scientifiques ont pour cela comparé le traitement d’une banque de sons par les différents modèles au traitement de ces mêmes sons par le cerveau de patients au travers de l’Imagerie par résonance magnétique fonctionnelle (IRMf)2 . En proposant un cadre et une méthodologie pour comparer les modèles d’écoute artificielle, ces résultats publiés dans Nature Neuroscience le 16 mars 2023 pourraient avoir des implications significatives pour le développement de nouvelles technologies de reconnaissance des sons inspirée du cerveau.

- 1Ces réseaux de « neurones » peuvent comporter des millions d’entre eux, répartis en plusieurs dizaines de couches. Ces modèles d’intelligence artificielle peuvent « apprendre » à partir d’une base de donnée, avec la supervision d’un humain ou non.

- 2L’IRMf permettant de visualiser de manière indirecte l'activité cérébrale.

Intermediate acoustic-to-semantic representations link behavioral and neural responses to natural sounds. Bruno L. Giordano, Michele Esposito, Giancarlo Valente et Elia Formisano. Nature Neuroscience, le 16 mars 2023. DOI:10.1038/s41593-023-01285-9